De acordo com TrendForce, a memória HBM3 e HBM3e da nova geração terá um grande impacto na indústria de GPUs de Inteligência Artificial, particularmente devido ao crescente interesse por parte das empresas em incorporar o DRAM.

GPUs de IA de NVIDIA e AMD vindouras para aproveitar as habilidades dos projetos de memória HBM3 mais velozes.

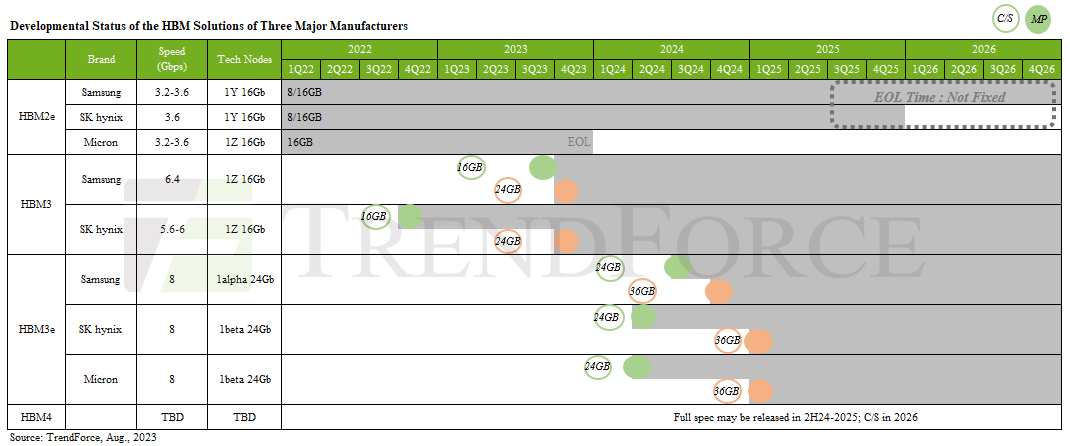

As GPU’s da NVIDIA A100 e H100, que foram lançadas em 2018 e 2020, utilizam respectivamente a memória HBM2e & HBM3. Fabricantes como Micron, SK Hynix e Samsung estão trabalhando na construção de instalações para a produção em massa de memória HBM3 mais rápida. Não será muito antes de ela tornar-se a nova referência.

As GPUs H100 da NVIDIA e a Fúria da Inteligência Artificial são ferramentas de ponta que ajudam a acelerar o desenvolvimento de IA. Um resumo da situação atual é que essas GPUs oferecem um poder computacional de alto desempenho, permitindo que os usuários criem redes neurais mais profundas e abordem problemas complexos de IA de forma mais eficiente. Com o aumento da demanda por tecnologias avançadas de IA, essas GPUs estão se tornando cada vez mais importantes para o desenvolvimento de sistemas de IA de ponta.

Muitas pessoas não têm conhecimento sobre um detalhe genérico ligado à memória HBM3. A TrendForce indicou que a HBM3 terá diferentes variações. O HBM3 mais baixo trabalhará a partir de 5,6 a 6,4 Gbps, enquanto as versões mais avançadas passarão de 8 Gbps. Estas variantes serão conhecidas como HBM3P, HBM3A, HBM3+ e HBM3 Gen2.

Recentemente, anunciamos que a indústria HBM experimentou um aumento significativo de sua fatia de mercado com a SK Hynix na liderança. As GPUs de IA Instinct AMD MI300 e H100 da NVIDIA deverão apresentar a HBM3 de última geração, e a SK Hynix liderará, pois ela já passou por etapas de produção e recebeu um pedido de amostra da NVIDIA.

Micron recentemente anunciou seus planos para o design futuro de memória HBM4, mas isso não é previsto para acontecer até 2026, o que significa que as próximas GPUs NVIDIA Blackwell, codinome “GB100”, provavelmente usarão as versões mais rápidas da memória HBM3 entre 2024-2025. A produção em massa da memória HBM3E que usa a tecnologia de processamento de 5ª geração (10nm) está prevista para começar no primeiro semestre de 2024, e ambas Samsung e SK Hynix devem expandir suas operações.

Concorrentes como Samsung e Micron têm aumentado o ritmo, já que inúmeros relatos giram em torno das organizações. Foi mencionado que a Samsung ofereceu à NVIDIA supervisionar tanto o wafer quanto a aquisição de memória por meio de seus setores. Ao mesmo tempo, a Micron alinhou-se ao TSMC para ser um fornecedor de memória para as GPUs AI da NVIDIA.

Nas anteriores considerações, abordamos as previsões da indústria da Inteligência Artificial segundo os números divulgados pela TrendForce. Os embarques de servidores AI são esperados para crescer 15,4%, e a CAGR (taxa de crescimento anual composta) é projetada para ser de 12,2% entre 2023 e 2027. Essa grande expansão dos embarques resultará em maior concorrência entre as empresas, o que por sua vez aumentará o impulso para a inovação.

Uma notícia sobre BusinessKorea é a fonte.